Teknolojik medeniyet varoluşsal bir paradoksla karşı karşıya. Büyük Dil Modellerinin (LLM) ve üretken sistemlerin yaygınlaşmasıyla yapay zeka (YZ) talebi katlanarak artarken, bu ilerlemeleri destekleyen fiziksel altyapı hızla aşılamaz termodinamik sınırlara yaklaşıyor. Moore Yasası’nın hakim anlatısı —transistörlerin ve verimliliğin sürekli ikiye katlanması— artık çatlamaya başladı. Bu durum, daha fazla küçültme yeteneğimizin olmamasından değil, ısı dağılımı ve enerji tüketiminin temel kısıtlamalarından kaynaklanıyor. İşte bu kritik bağlamda, yalnızca enerji krizini hafifletmeyi değil, aynı zamanda bilgi işlemenin doğasını yeniden tanımlamayı vaat eden bir paradigma değişimi olarak “termodinamik bilgi işlem” (thermodynamic computing) ortaya çıkıyor.

Üretken YZ Çağında Watt’ın Tiranlığı

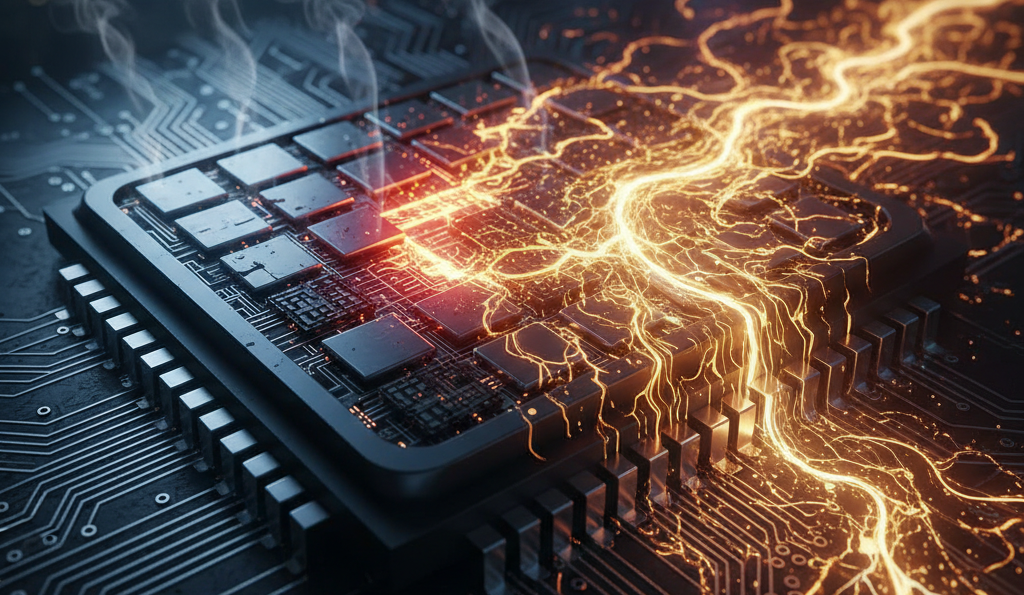

Von Neumann modeline ve deterministik Boole mantığına dayalı mevcut bilgisayar mimarisi, uzmanların “Enerji Duvarı” olarak adlandırdığı engele toslamak üzere. Gelişmiş YZ modellerinin eğitimi ve çıkarımı (inference), neredeyse tamamen NVIDIA H100 gibi her yerde bulunan Grafik İşleme Birimlerine (GPU) bağımlı. Bu ünitelerin tek biri 700 watt’lık bir Termal Tasarım Gücüne (TDP) sahip ve HGX H100 sistemlerinde kümelendiklerinde tüketim raf başına 2.000 watt’ı aşıyor. Bu güç yoğunluğu, modern veri merkezlerini devasa soğutma altyapıları gerektiren, endüstriyel ölçekte su ve elektrik tüketen dijital fırınlara dönüştürüyor.

Makroekonomik veriler bu krizin yakın olduğunu doğruluyor. Goldman Sachs, veri merkezlerinden kaynaklanan küresel güç talebinin on yılın sonuna kadar %165 artacağını öngörüyor. Uluslararası Enerji Ajansı (IEA) ise veri merkezlerinin elektrik tüketiminin 2026 yılına kadar ikiye katlanarak 1.000 TWh’ye ulaşabileceğini tahmin ediyor; bu rakam Japonya’nın toplam elektrik tüketimine eşdeğer. Bu büyüme doğrusal değil, YZ modellerinin karmaşıklığının üstel eğrisini izliyor ve veri merkezi yöneticilerinin %92’sinin şebeke kısıtlamalarını ölçeklendirmenin önündeki en büyük engel olarak tanımladığı sürdürülemez bir durum yaratıyor.

Determinizmin İçsel Verimsizliği

Temel sorun sadece hesaplama miktarında değil, bunun fiziksel kalitesinde yatıyor. Güncel dijital bilgi işlem, gürültü bastırma rejimi altında çalışır. Bir bitin tartışmasız bir şekilde 0 veya 1 olduğunu garanti etmek için, transistörlerin elektronların doğal “termal gürültüsünü” çok aşan voltajlarda çalışması gerekir. Entropiye karşı verilen bu sürekli mücadele —kaotik bir fiziksel ortamda mükemmel düzeni koruma çabası— fahiş bir enerji maliyetini beraberinde getirir.

Dijital bir işlemicideki her mantıksal işlem, kapasitörlerin şarj edilip boşaltılmasını ve elektronların dirençler üzerinden hareket ettirilmesini içerir; bu da hesaplamaya katkıda bulunmayan ancak determinizmi dayatmak için gereken “sürtünmede” harcanan enerjiyi temsil eden atık ısı üretir. Araştırmacıların belirttiği gibi, geleneksel sistemler stokastikliği (rastgeleliği) bastırmak için “enerji öder”. Ayrıca, bellek ile işlem birimi arasındaki fiziksel ayrım (von Neumann darboğazı), enerjinin büyük bir kısmının verileri işlemek yerine sadece bir yerden bir yere taşımak için harcandığı anlamına gelir.

Termodinamik Alternatif

Bu senaryo karşısında termodinamik bilgi işlem, operasyonel ilkelerde radikal bir tersine çevirme öneriyor. Bu disiplin, termal gürültüyle savaşmak için enerji harcamak yerine, onu bir hesaplama kaynağı olarak kullanmayı amaçlıyor. Doğanın, termal dengeye yönelik gevşeme (relaxation) süreçleri aracılığıyla verimli bir şekilde hesaplama yaptığı öncülüne dayanır. Bilgisayar mimarisini bilginin altında yatan fizikle hizalayarak, karmaşık görevleri —özellikle üretken YZ’nin gerektirdiği olasılıksal örneklemeyi— dijital transistörlerden katbekat üstün bir verimlilikle gerçekleştirmek mümkün hale geliyor.

Bu yaklaşım sadece teorik değil. Extropic ve Normal Computing gibi şirketler, bu ilkeleri somutlaştıran donanımlar üretmeye başladılar ve mevcut teknolojilerden 10.000 kata kadar daha yüksek verimlilik vaat ediyorlar. Bu rapor, teknolojinin durumunu, fiziksel temellerini, kilit oyuncuları ve fizik tabanlı bilgi işleme geçişin jeopolitik ve ekonomik etkilerini kapsamlı bir şekilde analiz ediyor.

Fiziksel Temeller: Deterministik Bitten Stokastik P-Bit’e

Termodinamik bilgi işlemin temsil ettiği inovasyonun boyutunu kavramak için, devrelerin işleyişinin fiziksel düzeyine inmek şarttır. Geleneksel bir çip ile Termodinamik Örnekleme Birimi (TSU) arasındaki fark, bir derece farkı değil, ontolojik bir sınıf farkıdır.

Denge Dışı Termodinamik ve Hesaplama

Bu ilerlemeleri destekleyen genel teori, genellikle stokastik termodinamik olarak adlandırılan denge dışı istatistiksel fiziktir. Bu alan, bilgisayarlar gibi termal dengeden uzak sistemleri analiz etmek için araçlar sağlar. Klasik bilgi işlemde, bir bit bilgiyi silmek için gereken minimum enerjiyi belirleyen ve çevreye ısı yayan Landauer ilkesi izlenir. Ancak termodinamik bilgi işlem farklı dinamikler altında çalışır.

Termodinamik cihazlar, Langevin dinamikleri altında evrimleşecek şekilde tasarlanmıştır. Bu, fiziksel sistemin doğal olarak minimum enerji durumunu “aradığı” anlamına gelir. Matematiksel bir problem cihazın enerji manzarasına kodlanırsa, sistem problemi basitçe termal denge durumuna gevşeyerek çözer. Bu paradigmada hesaplama, zoraki mantıksal adımlar dizisi değil, bir su damlasının dağdan aşağı en hızlı yolu bulması veya bir proteinin optimum konfigürasyonuna katlanması gibi doğal bir fiziksel süreçtir.

Olasılıksal Bit (p-bit)

Bu yeni mimarinin temel birimi p-bit’tir (olasılıksal bit). Değişmesi emredilene kadar statik olan dijital bir bitin aksine, p-bit, ortamdaki termal gürültü tarafından yönlendirilen nanosaniye zaman ölçeklerinde sürekli olarak 0 ve 1 arasında dalgalanır. Ancak bu dalgalanma tamamen rastgele değildir; kontrol voltajları aracılığıyla p-bitin zamanın örneğin %80’ini 1 durumunda ve %20’sini 0 durumunda geçirmesi sağlanabilir (bias).

Bu davranış olasılık dağılımlarını taklit eder. Birden fazla p-bit birbirine bağlanarak, karmaşık bir ortak olasılık dağılımını temsil eden bir devre oluşturulur. Devrenin durumu herhangi bir anda “okunduğunda”, o dağılımın geçerli bir örneği elde edilir. Bu çok önemlidir çünkü modern üretken YZ temel olarak olasılıklarla ilgilidir: en olası bir sonraki kelimeyi tahmin etmek veya bir görüntüdeki en makul pikseli oluşturmak.

Yerel Örnekleme vs. Dijital Simülasyon

Extropic tarafından ilan edilen “10.000 kat” verimlilik avantajı bu yapısal farktan kaynaklanmaktadır. Dijital (deterministik) bir GPU’da, karmaşık bir dağılımdan rastgele bir örnek oluşturmak, binlerce saat döngüsü ve milyonlarca transistör geçişi tüketen sözde rastgele sayı üreteci (PRNG) algoritmalarının çalıştırılmasını gerektirir. GPU, şansı karmaşık deterministik aritmetik yoluyla simüle etmek zorundadır.

Buna karşılık, termodinamik çip örneği yerel (native) olarak üretir. Gürültüyü simüle etmez; gürültü hesaplamanın motorudur. Fizik, rastgeleliği oluşturma işini üstlenir ve bu özel görev için karmaşık Aritmetik Mantık Birimlerine (ALU) olan ihtiyacı ortadan kaldırır. Bu, özünde, fiziksel ortamın matematiksel işlemi anında gerçekleştirdiği, gürültü destekli analog hesaplamadır.

Tablo: Operasyonel Özelliklerin Karşılaştırması

| Operasyonel Özellik | Dijital Bilgi İşlem (GPU/CPU) | Termodinamik Bilgi İşlem (TSU) |

| Temel Birim | CMOS Transistör (Deterministik Anahtar) | p-bit (Stokastik Osilatör) |

| Gürültü ile İlişki | Bastırma (Gürültü = Hata) | Kullanım (Gürültü = Kaynak/Yakıt) |

| Hesaplama Mekanizması | Sıralı Boole Aritmetiği | Minimum Enerji Durumuna Fiziksel Gevşeme |

| Enerji Tüketimi | Yüksek (Termodinamikle savaşır) | Minimum (Termodinamikle akar) |

| İdeal Uygulama | Kesin hesaplamalar, kesin mantık | Olasılıksal çıkarım, Optimizasyon, Üretken YZ |

Extropic: Mimari ve Belirsizlik Stratejisi

ABD merkezli Extropic, bu teknolojinin ticari öncüsü olarak konumlandı. Guillaume Verdon (eski Google fizikçisi ve dijital dünyada “Beff Jezos” olarak bilinen, etkili hızlanmacılık veya e/acc hareketinin lideri) ve Trevor McCourt tarafından kurulan şirket, teoriden somut silikon üretimine geçti.

X0 Çipi: Olasılıksal Silikonun Doğrulanması

Extropic’in ilk somut kilometre taşı X0 çipidir. Bu cihaz, olasılıksal devrelerin standart yarı iletken süreçleri kullanılarak üretilebileceğini ve oda sıcaklığında çalışabileceğini doğrulamak için tasarlanmış bir test prototipidir. Mutlak sıfıra yakın sıcaklıklar gerektiren kuantum bilgisayarların aksine X0, entropi kaynağı olarak ortam ısısını kullanır.

X0, ilkel olasılık dağılımlarından örnekler oluşturmak için tasarlanmış bir devre ailesini barındırır. Birincil işlevi, Extropic’in gürültü modellerinin doğruluğunu teyit etmekti: bir transistörün öngörülebilir ve kontrol edilebilir bir şekilde “gürültülü” olacak şekilde tasarlanabileceğini kanıtlamak. Bu önemli bir başarıdır çünkü yarı iletken endüstrisi 60 yılını gürültüyü ortadan kaldırmak için süreçleri optimize etmeye harcadı; bunu kontrollü bir şekilde geri getirmek, malzeme fiziğine derin bir hakimiyet gerektirir.

Geliştirme Platformu XTR-0

Araştırmacıların ve geliştiricilerin bu yeni fizikle etkileşime girmesine olanak tanımak için Extropic, XTR-0 platformunu piyasaya sürdü. Bu sistem bağımsız bir bilgisayar değil, hibrit bir mimaridir. Fiziksel olarak, geleneksel bir CPU ve bir FPGA barındıran trapezoidal bir anakart ile termodinamik X0 çiplerini içeren iki yavru karttan oluşur.

XTR-0’ın işlevi bir köprü görevi görmektir. CPU genel iş akışını ve deterministik mantığı yönetirken, FPGA, talimatları ve parametreleri X0 çiplerine gönderen ve üretilen olasılıksal örnekleri alan yüksek hızlı bir çevirmen görevi görür. Bu mimari pragmatik bir gerçeği kabul eder: termodinamik bilgisayarlar, bir işletim sistemini çalıştırmak veya bir hesap tablosunu işlemek gibi görevler için dijital bilgisayarların yerini almayacaktır. Rolleri, GPU’ların grafikleri hızlandırmasına benzer şekilde, ancak yalnızca YZ’nin olasılıksal iş yüküne adanmış özelleşmiş hızlandırıcılar olmaktır.

Z1 Çipi ve Ölçek Vizyonu

Extropic’in nihai hedefi X0 değil, gelecekteki Z1 çipidir. Bu cihazın yüz binlerce veya milyonlarca birbirine bağlı p-bit barındıracağı ve derin üretken YZ modellerinin tamamen termodinamik alt tabaka üzerinde çalıştırılmasına olanak tanıyacağı öngörülüyor. Şirket tarafından yapılan simülasyonlar, bu çipin görüntü veya metin oluşturma görevlerini eşdeğer bir GPU’dan 10.000 kat daha az enerji tüketerek gerçekleştirebileceğini gösteriyor.

Z1’in mimarisi devasa yerel bağlantıya dayanır. Verilerin çip üzerinde uzun mesafeler kat ettiği (ve enerji tükettiği) GPU’ların aksine, Extropic’in tasarımında bellek ve hesaplama iç içe geçmiştir. P-bitler yalnızca en yakın komşularıyla etkileşime girerek küresel sorunları topluca çözen yerel etkileşimlerden oluşan bir ağ oluşturur. Bu, veri hareketiyle ilişkili enerji maliyetinin büyük bir kısmını ortadan kaldırır.

Yerel Algoritmalar: Termodinamik Gürültü Giderme Modeli (DTM)

Devrim niteliğindeki donanım, devrim niteliğinde yazılım gerektirir. Standart derin öğrenme algoritmalarını (deterministik matris çarpımına dayalı) termodinamik bir çip üzerinde çalıştırmaya çalışmak verimsiz olurdu. Bu nedenle Extropic, yeni bir yerel algoritma sınıfı geliştirdi.

Enerji Tabanlı Modeller (EBM’ler)

Extropic yazılımının teorik temeli Enerji Tabanlı Modellerdir (Energy-Based Models – EBMs). Makine öğreniminde bir EBM, gerçekçi görünen verilerle (bir kedi resmi gibi) düşük “enerjiyi”, gürültü veya hatalı verilerle ise yüksek enerjiyi ilişkilendirmeyi öğrenir. Bir EBM ile veri oluşturmak, düşük enerjili konfigürasyonları bulmayı içerir.

EBM’ler teorik olarak onlarca yıldır var, ancak dijital bilgisayarlarda eğitilmeleri ve kullanılmaları son derece yavaş olduğu için derin sinir ağlarına karşı gözden düştüler. Gibbs Örneklemesi adı verilen bir işlem gerektirirler ki bu, bir CPU veya GPU üzerinde hesaplama açısından yasaklayıcıdır. Ancak Extropic’in çipi, Gibbs Örneklemesini yerel olarak ve neredeyse anında gerçekleştirir. Dijital silikon için bir zayıflık olan şey, termodinamik silikonun temel gücüdür.

Denoising Thermodynamic Model (DTM)

Extropic’in amiral gemisi algoritması, Termodinamik Gürültü Giderme Modeli’dir (DTM). Bu model, saf gürültüyle başlayan ve net bir görüntü elde edilene kadar onu aşamalı olarak iyileştiren modern difüzyon modellerine (Midjourney veya Stable Diffusion’a güç verenler gibi) benzer şekilde çalışır.

Ancak, bir GPU üzerindeki difüzyon modeli gürültünün nasıl giderileceğini adım adım matematiksel olarak hesaplamak zorundayken, DTM dönüşümü gerçekleştirmek için çipin fiziğini kullanır. Termodinamik donanım, “gürültülü” durumun termodinamik yasalarını izleyerek fiziksel olarak “düzenli” duruma (son görüntü) evrilmesine izin verir. Simülasyonlar, bu yaklaşımın yalnızca daha hızlı olmadığını, aynı zamanda “gürültü giderme” süreci trilyonlarca kayan nokta çarpımıyla değil, sistemin dengeye yönelik doğal eğilimiyle gerçekleştirildiği için çok daha az enerji gerektirdiğini göstermektedir.

Rekabetçi Ekosistem: Fiziksel Bilgi İşlemde Farklı Yaklaşımlar

Extropic, cesur iddiaları ve siberpunk estetiğiyle medyanın dikkatini çekmiş olsa da bu alandaki tek oyuncu değil. Termodinamik ve olasılıksal bilgi işlem yarışı, her biri farklı teknik ve pazar felsefelerine sahip Normal Computing gibi diğer sofistike rakipleri de içeriyor.

Normal Computing: Stokastisite Yoluyla Güvenilirlik

New York merkezli ve eski Google Brain ve Alphabet X mühendisleri tarafından kurulan Normal Computing, soruna biraz farklı bir açıdan yaklaşıyor. Extropic üretim için hıza ve ham verimliliğe (akselerasyonizm) odaklanırken, Normal kritik sistemlerde güvenilirlik, güvenlik ve belirsizliğin ölçülmesine önemli bir vurgu yapıyor.

Teknolojileri Stokastik İşlem Birimi’ne (SPU) dayanıyor. Extropic gibi onlar da termal gürültü kullanıyor, ancak matematiksel çerçeveleri Ornstein-Uhlenbeck (OU) süreci gibi belirli stokastik süreçlere odaklanıyor. OU süreci, dalgalanan ancak kararlı bir merkeze dönme eğiliminde olan sistemleri modellemek için yararlı olan, ortalamaya dönen bir stokastik süreçtir.

Normal Computing, CN101 çipinin “tape-out” (üretime hazır tasarımın tamamlanması) aşaması gibi önemli kilometre taşlarına ulaştı. Bu çip, termodinamik mimarinin gerçek silikon üzerindeki uygulanabilirliğini göstermek için tasarlandı. Yol haritaları, 2027-2028 yılına kadar yüksek çözünürlüklü difüzyon modellerini ve videoyu ölçeklendirmeyi amaçlayan gelecekteki CN201 ve CN301 çiplerini içeriyor.

Temel Fark: Extropic, düşük enerji maliyetiyle maksimum entropi ve üretken yaratıcılık için optimize ediyor gibi görünüyor (sanat, metin, fikir üretimi için ideal). Normal Computing ise YZ’nin “neyi bilmediğini bilmesi” ve iş veya endüstriyel uygulamalarda riskleri yönetmesi için olasılıksal donanımı kullanarak “açıklanabilir YZ” ve güvenilirlik için optimize ediyor.

Nöromorfik vs. Termodinamik Bilgi İşlem

Termodinamik bilgi işlemi, nöromorfik bilgi işlemden (IBM’in TrueNorth veya Intel’in Loihi çipleriyle temsil edilen) ayırt etmek çok önemlidir. Nöromorfik bilgi işlem, genellikle deterministik dijital veya analog devreler kullanarak beynin biyolojik mimarisini (nöronlar, sinapslar, voltaj yükselmeleri) taklit etmeye çalışır.

Termodinamik bilgi işlem ise beynin fiziğini taklit eder. Biyolojik beyin, 37°C’de ıslak ve gürültülü bir ortamda çalışır; kimyasal reaksiyonları ve sinyal iletimini kolaylaştırmak için termal gürültüyü kullanır. Gürültüyle savaşmaz; onu kullanır. Extropic ve Normal Computing, fiziği (termodinamik) taklit etmenin, sadece yapıyı (nöromorfik) taklit etmekten daha doğrudan bir verimlilik yolu olduğunu savunuyor.

Derinlemesine Verimlilik Analizi: “10.000 Kat”ın Yapıbozumu

10.000 kat verimlilik artışı iddiası olağanüstüdür ve titiz bir teknik inceleme gerektirir. Bu rakam tam olarak nereden geliyor ve üretim ortamlarında gerçekçi mi?

Tasarrufun Fiziği

Enerji tasarrufu üç ana kaynaktan gelir:

- Veri Hareketinin Ortadan Kaldırılması: Bir GPU’da, model ağırlıklarını VRAM belleğinden okumak, hesaplamanın kendisinden daha fazla enerji tüketir. Extropic’in TSU’sunda model ağırlıkları, p-bitler arasındaki bağlantılarda fiziksel olarak kodlanmıştır. Hesaplama, verilerin olduğu yerde gerçekleşir.

- Pasif Hesaplama: Dijital bir devrede saat (clock), durum geçişlerini saniyede milyonlarca kez zorlayarak her döngüde aktif enerji tüketir. Termodinamik bir devrede sistem pasif olarak çözüme doğru evrilir. Enerji büyük ölçüde ortam ısısı (termal gürültü) tarafından sağlanır, ki bu “bedavadır”.

- Örnekleme Verimliliği: Tartışıldığı gibi, dijital ortamda istatistiksel bir örnek oluşturmak binlerce işlem gerektirir. Termodinamikte bu tek bir işlemdir. Bir görev milyonlarca örnek almayı gerektiriyorsa (video üretiminde olduğu gibi), avantaj doğrusal olarak birikerek devasa boyutlara ulaşır.

Gerçek Tüketim Karşılaştırması

Bunu bir perspektife oturtmak için LLaMA tipi modellerin eğitimini ve çıkarımını ele alalım. Meta, LLaMA 3’ü 16.000 H100 GPU kullanarak eğitti. Muhafazakar bir ortalama tüketim varsayarsak, enerji maliyeti yüzlerce gigawatt-saat tutarındadır. Çıkarım aşamasında (günlük kullanım), milyonlarca kullanıcı modeli sorgularsa, kümülatif tüketim eğitiminkini aşar.

Eğer termodinamik bir çip aynı çıkarımı yüzlerce watt yerine miliwatt tüketerek gerçekleştirebilirse, YZ’nin ekonomik uygulanabilirliği radikal bir şekilde değişir. Bu, pili dakikalar içinde tüketmeden bir akıllı telefonda GPT-4 seviyesinde modeller çalıştırmayı veya tarımda küçük bir pille yıllarca çalışan akıllı sensörler yerleştirmeyi mümkün kılabilir.

Sınırlamalar ve Uyarılar

Bununla birlikte, 10.000 kat rakamı, bu donanım için optimize edilmiş belirli kıyaslamaların (benchmarks) simülasyonlarından türetilmiştir. Deterministik mantık, veri ön işleme ve CPU iletişiminin gerekli olduğu karma iş yüklerinde, küresel sistem verimliliği (Amdahl Yasası) daha düşük olacaktır. Ayrıca, analog hassasiyet doğası gereği sınırlıdır. Kesin 64-bit hassasiyet gerektiren finansal hesaplamalar için termodinamik bilgi işlem uygun değildir. Nişi kesin muhasebe değil, olasılıksal çıkarımdır.

Tablo: Verimlilik Manzarası

| Verimlilik Metriği | Dijital GPU (H100) | Termodinamik TSU (Öngörülen) | Teorik İyileştirme Faktörü |

| Joule Başına İşlem | Landauer bariyeri ve CMOS mimarisi ile sınırlı | Sadece arka plan termal gürültüsü ile sınırlı | ~10^3 – 10^5 |

| Örnekleme Gecikmesi | Yüksek (sıralı PRNG yinelemeleri gerektirir) | Çok Düşük (fiziksel olarak anlık) | ~100x – 1000x |

| Devre Karmaşıklığı | Yüksek (kontrol mantığı için milyonlarca transistör) | Düşük (basit p-bitler ve bağlantılar) | Yüksek alan yoğunluğu |

Üretim ve Ölçeklenebilirlik Zorlukları: Donanımın Ölüm Vadisi

Bilgisayar tarihi, ölçeklendirmeye çalışırken başarısız olan umut verici teknolojilerle (memristörler, optik bilgi işlem, spintronik) doludur. Termodinamik bilgi işlem, laboratuvardan çıkmak için önemli engellerle karşı karşıyadır.

Süreç Değişkenliği ve Kalibrasyon

Extropic ve Normal Computing için en büyük zorluk homojenliktir. Modern çip üretiminde (5nm veya 3nm düğümleri), transistörler arasında mikroskobik farklılıklar vardır. Dijitalde bu, güvenlik marjları ile yönetilir. “Gürültünün” sinyal olduğu analog/termodinamikte, transistör boyutundaki bir değişiklik olasılık profilini değiştirir.

Üretim hataları nedeniyle her p-bit biraz farklı bir eğilime (bias) sahipse, çip doğru olasılık dağılımını temsil etmeyecektir. Bu varyasyonları telafi etmek için milyonlarca bireysel p-biti kalibre etmek, enerji ve alan tasarrufunun bir kısmını yiyebilecek devasa dijital kontrol devreleri gerektirebilir. Extropic bunu sağlam devre tasarımlarıyla çözdüğünü iddia ediyor, ancak gerçek test Z1 çipinin seri üretimiyle gelecek.

Yazılım Ekosistemi Entegrasyonu

Ekosistemi olmayan donanım işe yaramaz. NVIDIA, sadece çipleriyle değil, yazılım katmanı CUDA ile YZ’ye hükmediyor. Geliştiricilerin TSU’ları benimsemesi için fiziksel karmaşıklığın soyutlanması gerekir. Extropic, geliştiricilerin enerji modelleri tanımlamasına ve bunları arka planda (ister GPU’da simüle edilmiş ister XTR-0’da gerçek olsun) çalıştırmasına olanak tanıyan Thrml adlı bir Python kütüphanesi yayınladı. Başarı, bu entegrasyonun PyTorch ve TensorFlow ile ne kadar şeffaf olduğuna bağlı olacaktır. Makine öğrenimi mühendislerinin çipi programlamak için istatistiksel fizik öğrenmesi gerekirse, benimsenme sıfır olacaktır.

Moore Yasası Rekabeti

Dijital teknoloji yerinde saymıyor. NVIDIA, AMD ve Intel mimarilerini YZ için optimize etmeye devam ediyor (örneğin FP8 hassasiyeti, Blackwell mimarileri). Termodinamik bilgi işlem hareketli bir hedefi kovalıyor. Z1 çipi ticari pazara ulaştığında, geleneksel GPU’lar verimliliklerini artırmış olacaklar. “10.000 kat” avantajı büyük bir tampon, ancak fırsat penceresini kaçırmamak için uygulama hızlı olmalı.

Jeopolitik ve Ekonomik Etkiler

Bu teknolojinin ortaya çıkışı, sunucu odasının ötesine uzanan, ulusal stratejiyi ve küresel YZ ekonomisini etkileyen sonuçlara sahiptir.

YZ Egemenliği ve Merkezsizleşme

Şu anda gelişmiş YZ, milyar dolarlık veri merkezlerini finanse edebilen ve kısıtlı GPU tedarikine erişebilen kuruluşlar tarafından kontrol edilen bir oligopoldür. Termodinamik bilgi işlem, enerji ve donanım maliyetlerini büyük ölçüde düşürerek (çalışmak için en son 3nm litografisine ihtiyaç duymadıklarından daha eski, daha ucuz silikon üretim süreçlerini kullanarak), “süper zekaya” erişimi demokratikleştirebilir.

Bu, daha küçük ulusların veya orta ölçekli şirketlerin, Amerikan hiper ölçekleyicilerin (Microsoft, Google, Amazon) bulutlarına bağımlı olmadan kendi temel modellerini çalıştırmalarına olanak tanır. Bu, daha büyük bir teknolojik egemenlik için potansiyel bir vektördür.

Şebeke Etkisi ve Sürdürülebilirlik

IEA ve hükümetler veri merkezi tüketiminden endişeli. İrlanda veya Kuzey Virginia gibi yerlerde veri merkezleri toplam şebekenin çift haneli yüzdelerini tüketiyor. Termodinamik bilgi işlem bu baskı için bir “tahliye vanası” sunuyor. Endüstri, çıkarım yüklerinin bir kısmını termodinamik donanıma kaydırırsa, YZ’nin büyümesini karbon ayak izinin büyümesinden ayırmak mümkün olabilir, bu da teknolojik ilerlemeyi frenlemeden iklim hedeflerine ulaşmayı sağlar.

Hızlanmacılık Felsefesi (e/acc)

İdeolojik bileşen göz ardı edilemez. Extropic’in CEO’su Guillaume Verdon, evrenin ahlaki ve termodinamik bir zorunluluğu olarak sınırsız ve hızlı teknolojik ilerlemeyi savunan e/acc hareketinin merkezi bir figürüdür. Extropic sadece bir şirket değil; bu ideolojinin fiziksel tezahürüdür. Evrenin entropi ve zeka üretimini maksimize etmeyi amaçlıyorlar. Bu, “Yavaşlama” veya “YZ Güvenliği” (Safetyism) vizyonlarıyla tezat oluşturuyor. Extropic’in başarısı, Silikon Vadisi’ndeki hızlanmacı kamp için kültürel ve teknik bir zafer olacaktır.

Doğal Zekanın Şafağı

Termodinamik bilgi işlem, yapay ve doğal hesaplama arasındaki boşluğu kapatmak için bugüne kadarki en ciddi girişimi temsil ediyor. Yetmiş yıl boyunca, katı bürokrasiler gibi çalışan bilgisayarlar inşa ettik: kesin kuralları izleyen, verileri kesin konumlarda arşivleyen ve hiçbir şeyin normdan sapmamasını sağlamak için muazzam enerji harcayan. Bu arada insan beyni —ve doğanın kendisi— bir caz sanatçısı gibi işledi: doğaçlama yaparak, gürültüyü ve kaosu melodinin bir parçası olarak kullanarak ve şaşırtıcı bir enerji verimliliğiyle parlak sonuçlar elde ederek.

Extropic ve Normal Computing tarafından X0 ve CN101 gibi cihazlar aracılığıyla sunulan teknolojiler, bu ikinci yaklaşımı benimsemeye hazır olduğumuzu gösteriyor. 10.000 kat enerji verimliliği vaadi sadece aşamalı bir iyileştirme değil; yapay zekanın her yerde bulunmasını (ubiquity) sağlayacak bir faz değişikliğidir.

Ancak yol, teknik risklerle dolu. Dijital determinizmden termodinamik olasılıkçılığa geçiş, sadece yeni çipler değil, algoritmalar, hassasiyet ve hesaplamanın doğası hakkında nasıl düşündüğümüze dair tam bir yeniden eğitim gerektirecektir. Extropic p-bitlerini ölçeklendirmeyi başarır ve Normal Computing stokastik süreçlerinin güvenliğini sertifikalandırabilirse, on yıl içinde bugünkü GPU’lara —o 700 watt’lık silikon fırınlara— bugün 1940’ların vakum tüplerine baktığımız aynı nostalji ve şaşkınlıkla bakmamız mümkün. Termodinamikle savaşma çağı sona erdi; onunla hesaplama çağı başladı.

Post-Dijital Bilgi İşlem Manzarası

| Boyut | Klasik Dijital Yaklaşım | Termodinamik Yaklaşım (Extropic/Normal) |

| Felsefe | Tam kontrol, hata bastırma | Kaosun kabulü, gürültü kullanımı |

| Fiziksel Sınır | Isı dağılımı, Moore Yasası | Temel entropik sınırlar |

| YZ Modeli | Derin Sinir Ağları (DNN) | Enerji Tabanlı Modeller (EBM), Difüzyon |

| Donanım | GPU, TPU (Yüksek Güç) | TSU, SPU (Düşük Güç, Pasif) |

| Gelecek Vizyonu | Şehir büyüklüğünde veri merkezleri | Her yerde bulunan, merkeziyetsiz ve ortam zekası |